简介

主页:https://apchenstu.github.io/mvsnerf/

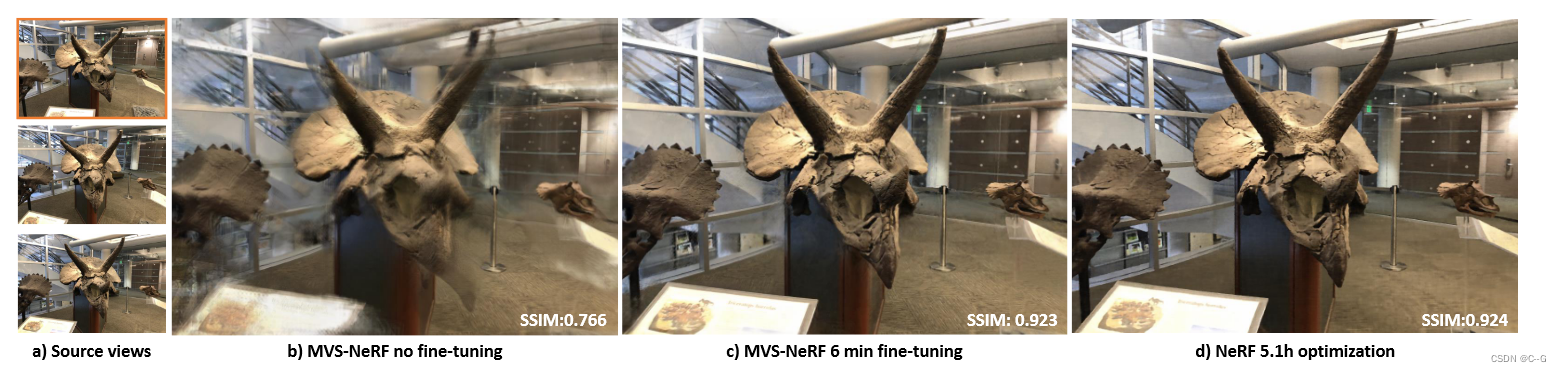

提出了一种新的神经渲染方法MVSNeRF,它可以有效地重建用于视图合成的神经辐射场。与先前关于神经辐射场的工作不同,这些工作考虑对密集捕获的图像进行逐场景优化,提出了一种通用的深度神经网络,该网络可以通过快速网络推理仅从三个附近的输入视图重建辐射场。利用plane-swept cost volumes(广泛用于multi-view stereo)进行几何感知场景推理,并将其与基于物理的体渲染相结合进行神经辐射场重建

Multi-view stereo

MVS是一个经典的计算机视觉问题,旨在使用从多个视点捕获的图像实现密集的几何结构重建dense geometry reconstruction

深度学习技术已被引入解决MVS问题。MVSNet 在参考视图的平面扫描成本体积上应用3D CNN进行深度估计,实现了优于经典传统方法的高质量3D重建

实现流程

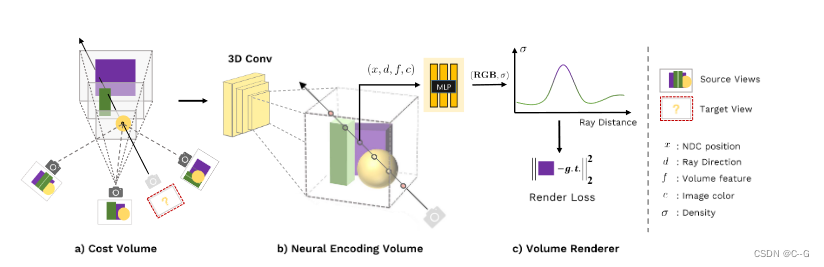

首先通过将二维图像特征扭曲到平面扫描上来构建一个cost volume(a)。然后,我们使用3D CNN来重建一个带有每个体素神经特征的neural encoding volume。我们使用MLP来回归任意位置的体积密度和RGB亮度,使用从encoding volume中插值的特征。这些体积特性被用于可微射线行进的最终渲染©。

x代表3d位置,d是视图方向,σ是x方向的体密度,r是x处的输出亮度(RGB颜色)取决于观察方向d,捕获图像Ii,新视角相机参数Φi

Cost Volume

将m个输入图像中的2D图像特征扭曲到参考视图的挫折面上的一个平面扫描体,在参考视图reference view(i = 1)构建了一个cost volume P,允许几何感知场景理解

Extracting image features

使用深度二维CNN T来提取各个输入视图的二维图像特征,从而有效地提取代表局部图像外观的二维神经特征,使用下采样卷积层将图像Ii(H x W x 3)卷积为特征图Fi(H/4 x W/4 x C),C为通道数

Warping feature maps

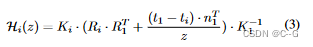

通过给定的相机的内外参数Φ = [K, R, t]进行同形扭曲

Hi(z)为视图i到深度z的参考视图的扭曲矩阵,K为本征矩阵,R和t是相机旋转矩阵和平移矩阵,所以特征图都进行如下变换

Fi,z 为深度z处的扭曲特征图,(u,v)为参考视图中的像素位置,在这里,使用参考视图中的归一化设备坐标 (NDC)来参数化(u,v,z)。

Cost volume

cost volumeP由D 扫描平面(sweeping planes)的扭曲特征图(warped feature maps)构造而成,利用基于方差的度量(variance-based metric)来计算成本(cost),对于以(u,v,z)为中心的P中的每个体素voxel,其成本特征向量cost feature vector由下式计算

Var计算M个视图的方差,这种基于方差的成本体对不同输入视图上的图像外观变化进行编码;这解释了由场景几何体和视图相关的着色效果shading effects引起的外观变化

Radiance field reconstruction

利用3D CNN B从原始2D image feature costs的cost volume P中重建neural encoding volume S;S由编码局部场景几何形状和外观的每个体素特征组成。MLP decoder A 用于从该编码体回归体渲染属

Neural encoding volume

训练一个深度3D CNN B,将构建的image-feature cost volume转换为新的C通道神经特征体积 S,其中特征空间由网络自身学习和发现,用于后续的体积属性回归

3D CNN B是一个具有下采样和上采样卷积层和跳跃连接的3D UNet,可以有效地推断和传播场景外观信息,从而产生有意义的场景编码体S,网络可以学习在每个体素的神经特征中编码有意义的场景几何和外观;这些特征随后被连续地内插和改变

Regressing volume properties

给定一个任意的3D位置x和一个观看方向d,我们使用MLP a从神经编码体积s回归相应的体积密度σ和视相关的亮度r

这里同时将原始图像Ii的像素颜色 c= [I(ui, vi)] ( (ui, vi)是在视图i上投影3D点x时的像素位置 )作为额外输入,由于2D特征提取的下采样,场景编码体具有相对低的分辨率;仅从这些信息中回归高频出现是具有挑战性的。因此,引入了原始图像像素数据

f = S(x)是在位置x处从volume S三线性内插的神经特征

x在参考视图的NDC空间中被参数化,而d由参考视图坐标处的单位向量表示。使用NDC空间可以有效地归一化跨不同数据源的场景比例,有助于良好的可推广性

对位置和方向向量(x和d)应用了位置编码

补充细节

在得到体密度和视点相关辐射后,后续于原始NeRF基本一致.

整个框架模拟了一个神经辐射场,从几个(三个)输入图像回归场景中的体积密度和视点相关辐射率。此外,一旦场景编码体积S被重建,与MLP解码器A结合的该体积可以被独立使用,而无需预先考虑2D和3D CNNs。它们可以被视为辐射场的独立神经表示,输出体属性,从而支持体渲染。

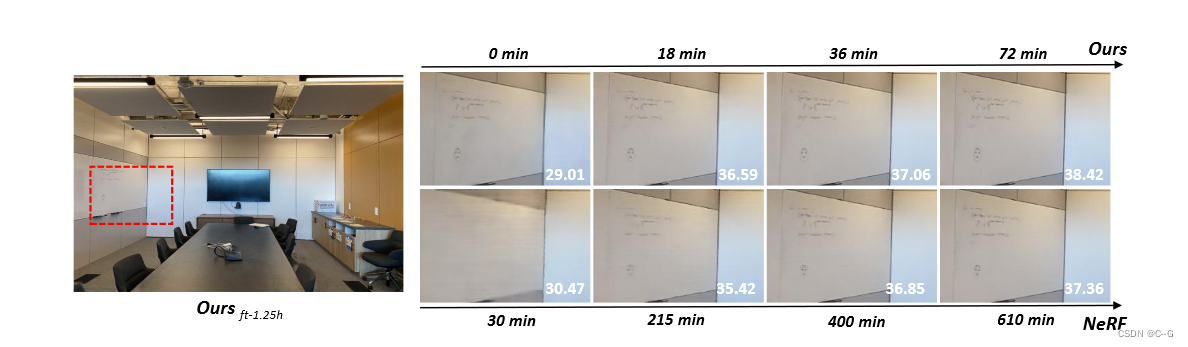

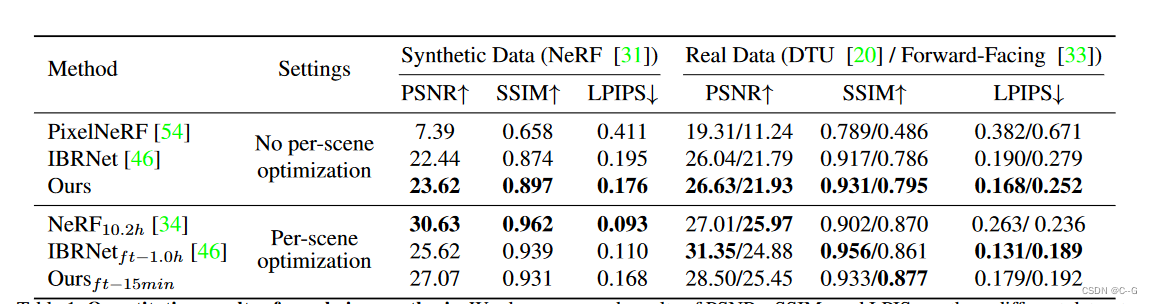

效果

版权声明:本文内容由互联网用户自发贡献,该文观点与技术仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌侵权/违法违规的内容, 请发送邮件至 dio@foxmail.com 举报,一经查实,本站将立刻删除。